so-vits-svc是一个用来模拟人声的开源项目,该工具可以帮助大家更好的对声音模型进行训练,用于生成类似微软云希、抖音文字转语音等效果,对电脑硬件的要求并不高,但是需要较为繁琐的准备工作,还有大量的声音素材,经过训练之后,大家就可以通过AI的方式来进行声音的模拟和歌唱。

【使用教程】

如果您想训练自己的声音模型并加以使用,需要以后几个步骤。

提取干音

音频切分

预处理

训练模型

配置模型

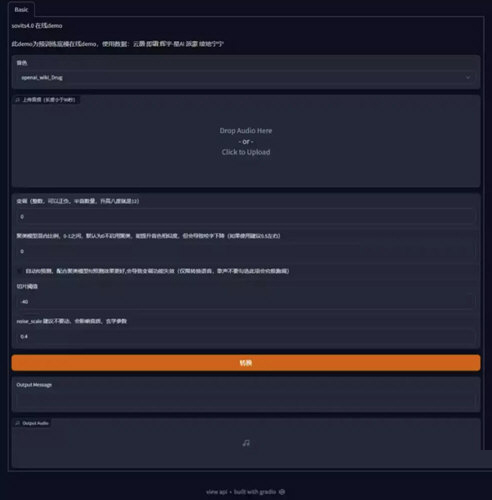

推理预测

【常见问答】

Q:跑这个的最低配置要求是啥啊?

A:支持CUDA的6G显存以上的N卡,硬盘也留足一点空间。

Q:A卡真的跑不了吗

A:理论上可以在Ubuntu或Linux环境下通过ROCm来实现,但是比较麻烦,小白建议放弃直接去云端。

Q:我的显卡达不到最低要求,云端又心疼钱,真的没法训练了吗?

A:建议去看DDSP-SVC项目,效果差一点但也能听,最重要的是对低配非常友好。

Q:用UVR5分离人声的时候声音会失真,还有什么更给力的工具吗?

A:理论上UVR5已经是目前最强的人声分离工具了,原曲如果伴奏声音太大轨道太复杂是一定会有失真的,建议选原曲的时候选择伴奏简单人声清楚的效果会好很多。

Q:Audio Slicer 切出来的音频有的长达几十秒甚至几分钟,是怎么回事?

A:切片长度建议5-15秒,训练时过长部分会被自动丢弃。切出来过长的音频可以调整一下slicer里的maximum silence length这一条,改成500或者更低。还有过长的音频就自己用Au之类的手动切一下啦。

Q:我怎么判断模型有没有训练好?

A:数据集数量正常的情况下(几百条),可以每隔几千步(是总步数不是epoch)跑出来的模型推理听一下,你觉得ok就ok,一般一万步就可以有一个不错的效果了。或者有代码基础的可以用tensorboard查看一下损失率收敛趋势。

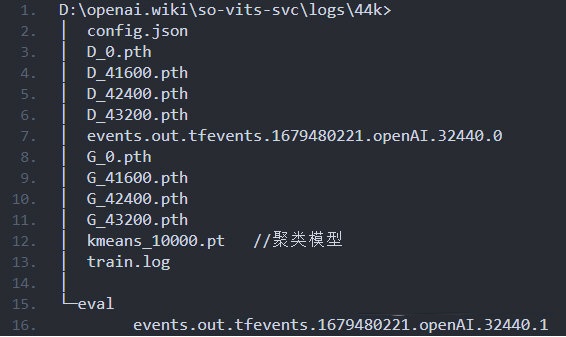

Q:那么问题来了,tensorboard怎么用?

A:python38\Scripts\tensorboard.exe --logdir logs\44k

Q:我在训练途中按CTRL+C暂停训练,继续训练的时候为什么从头开始/步数掉了很多呢?

A:视频里说的有点歧义,其实是从你上一个保存的模型的进度开始的,比如保存的一个模型是G_8000, 即使你训练到了第8799步,只要下一个模型还没保存,继续训练的时候都是从第8000步开始的。同理,如果一个模型也没保存,那就是从头开始训练。

Q:如果我在训练中途想要追加一些数据集该怎么办呢?

A:需要重新预处理并重新训练。

Q:我为什么没有聚类模型啊?

A:重看一遍教程。

Q:训练聚类模型的时候显卡根本没占用是怎么会是呢?

A:聚类模型训练吃的是你的CPU,看一下python进程在占用CPU就是在训练,等就行了。

Q:我实在是太懒了,只想让AI帮我读稿子,不想自己录原声再推理,有啥办法吗?

A:可以考一下VITS项目,最近有个VITS fast fine-tuning的方法,几分钟的素材就能练出比较相似的声音,虽然效果没那么好但它实在是太方便了。

Q:云端训练好的模型怎么在本地用?

A:下载G模型和对应的config文件,放到本地的对应文件夹就行(.\logs\44k和.\configs)

Q:我实在不会搞了,请问能代训练吗?有偿的那种。

A:可以,每1万步100元。

Q:我训练和推理都很顺利!现在已经做了一首翻唱了,想上传到网络,有什么注意事项吗?

A:请务必遵循So-VITS使用规约:

任何发布到视频平台的基于sovits制作的视频,都必须要在简介明确指明用于变声器转换的输入源歌声、音频,例如:使用他人发布的视频/音频,通过分离的人声作为输入源进行转换的,必须要给出明确的原视频、音乐链接;若使用是自己的人声,或是使用其他歌声合成引擎合成的声音作为输入源进行转换的,也必须在简介加以说明。

由输入源造成的侵权问题需自行承担全部责任和一切后果。使用其他商用歌声合成软件作为输入源时,请确保遵守该软件的使用条例,注意,许多歌声合成引擎使用条例中明确指明不可用于输入源进行转换。

请自行解决数据集的授权问题,任何由于使用非授权数据集进行训练造成的问题,需自行承担全部责任和一切后果。

∨ 展开

FL Studio 21中文破解版 v21.3.2304

FL Studio 21中文破解版 v21.3.2304

PyCharm2022专业版破解版 V2022.3 永久激活版

PyCharm2022专业版破解版 V2022.3 永久激活版

谷歌翻译助手插件 V1.0.1 免费版

谷歌翻译助手插件 V1.0.1 免费版

vCard Wizardv4.24.0237破解版

vCard Wizardv4.24.0237破解版

Dark Readerv4.9.4 官方最新版

Dark Readerv4.9.4 官方最新版

格式工厂PC中文版 V5.13.0 官方免费版

格式工厂PC中文版 V5.13.0 官方免费版

我的世界启动器网易版电脑版 V1.10.0.15222 官方PC版

我的世界启动器网易版电脑版 V1.10.0.15222 官方PC版

原创度检测工具v1.7 绿色版

原创度检测工具v1.7 绿色版

火山的女儿修改器 32位/64位 Steam版

火山的女儿修改器 32位/64位 Steam版

NaturalReader 16v16.1.2破解版

NaturalReader 16v16.1.2破解版

QVE人声分离v1.0.4破解版

QVE人声分离v1.0.4破解版

Studio One 6中文破解版 V6.0.2 最新免费版

Studio One 6中文破解版 V6.0.2 最新免费版

Adobe Audition CCv6.0.732绿色免注册破解版

Adobe Audition CCv6.0.732绿色免注册破解版

录音啦v5.2免安装绿色破解版

录音啦v5.2免安装绿色破解版

元气音频变声器 V1.0 免费版

元气音频变声器 V1.0 免费版

AutoTune pro 9v9.10破解版

AutoTune pro 9v9.10破解版