Screaming Frog Log File Analyzer一款支持跨平台使用日志文件分析软件。日志分析工具哪款好用呢?小编给大家推荐这款尖叫青蛙,它能够对你的网站日志进行深入的分析它允许用户将原始访问日志文件拖放到软件界面中进行分析,并且分析单个项目中的数千个日志事件,同时它还能够智能的识别大型和慢速URL,并查找未获取网址和孤立的URL,这款日志文件分析器虽然十分轻巧但是功能却十分的强大,足以处理存储和分析智能数据库中的数百万个日志文件事件数据,它收集关键日志文件数据,以便SEO做出明智的决定哦。日志文件数据非常有价值,因为它可以准确显示搜索引擎机器人访问您网站时发生的情况。但是,如果没有编程经验或正确的工具,日志文件的大小可能非常大并且难以分析。日志文件分析器专为SEO而设计,使此过程不那么痛苦。日志文件分析器支持Apache和W3C扩展日志文件格式,涵盖Apache,IIS和NGINX服务器。这也涵盖了Amazon Elastic Load Balancing自定义日志文件格式。只需拖放日志文件,或将文件直接记录到用户界面,该工具将自动处理数据,以便您可以在程序的用户界面中分析和过滤常见的SEO问题,或导出到CSV和Excel。SEO必备的一款日志分析器,而且小编带来的是Screaming Frog Log File Analyzer破解版,附带有注册机以及详细的安装破解图文教程帮助大家完成破解,有需要的朋友们可不要错过了哦!

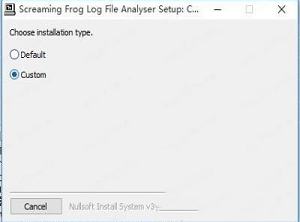

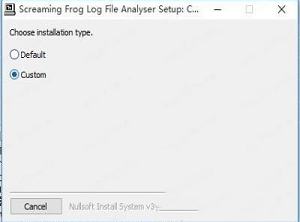

2、双击ScreamingFrogLogFileAnalyser-3.0.exe运行安装,如图所示,选择安装方式,默认安装和自定义安装;

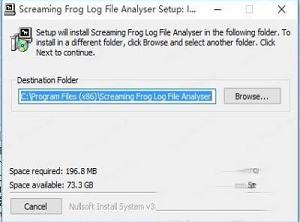

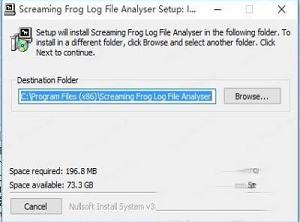

3、勾选Custom,如图所示,点击浏览选择软件安装路径,点击next;

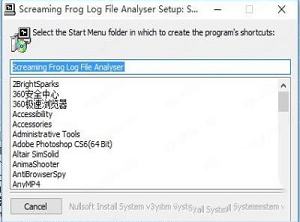

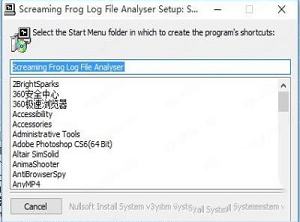

4、选择要在其中创建程序快捷方式的“开始菜单”文件夹,默认即可点击next;

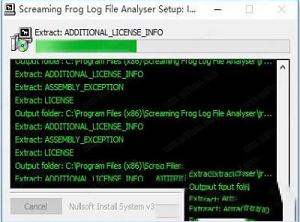

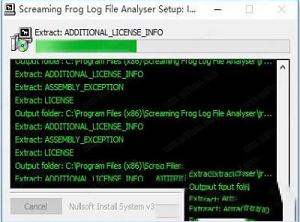

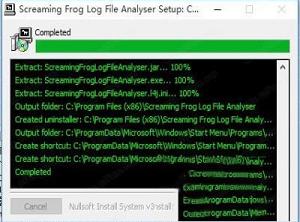

5、安装中,大家耐心等待一会儿;

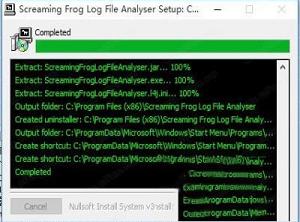

6、安装完成,点击closet关闭;

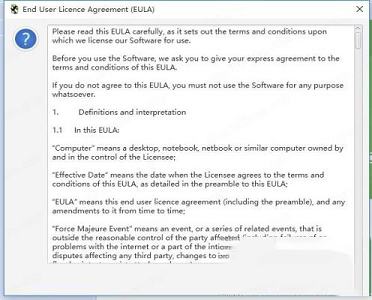

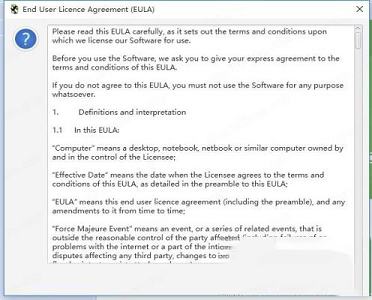

7、运行软件,点击 Accept;

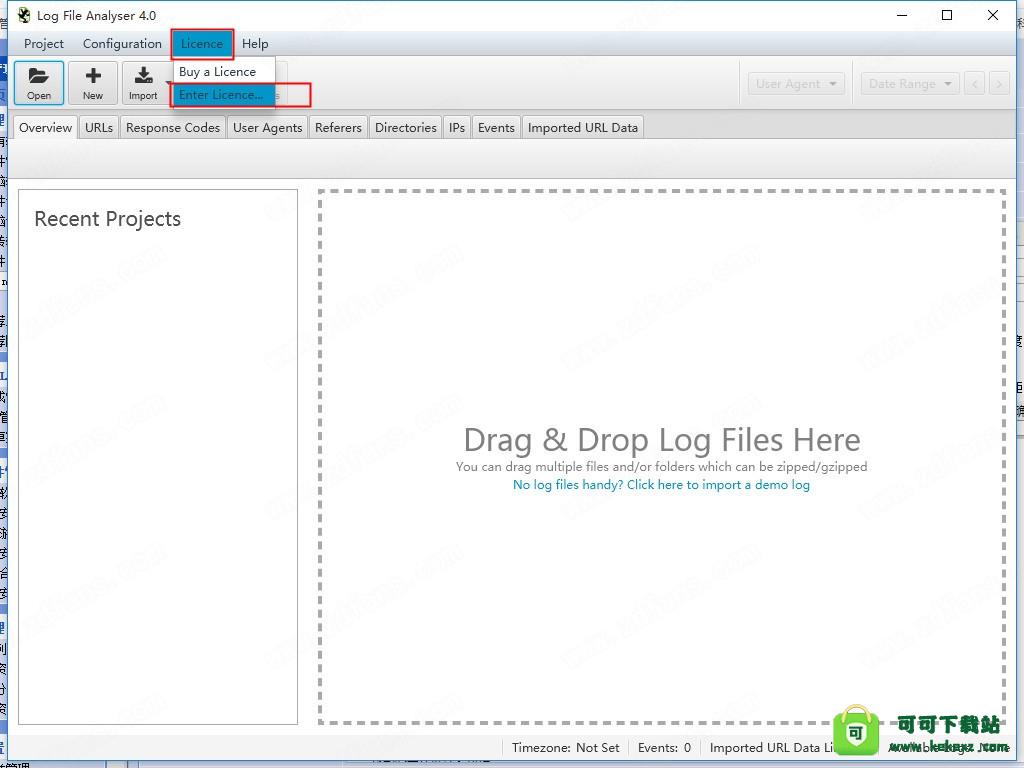

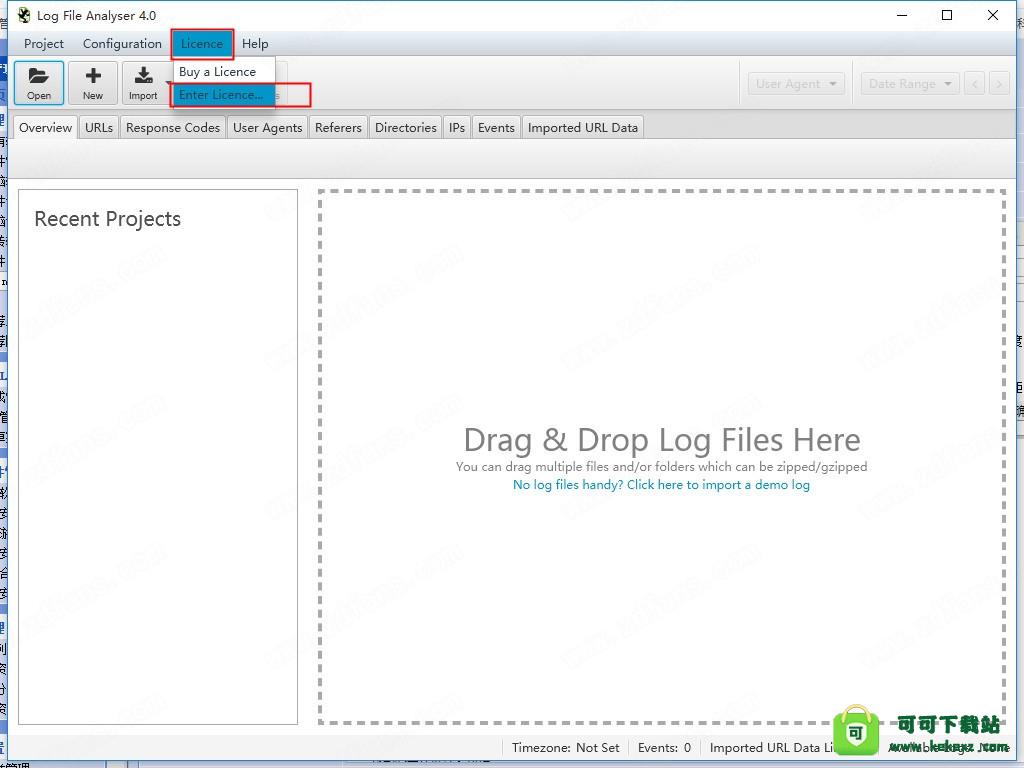

8、如图所示,依次选择Licence-enter Licence;

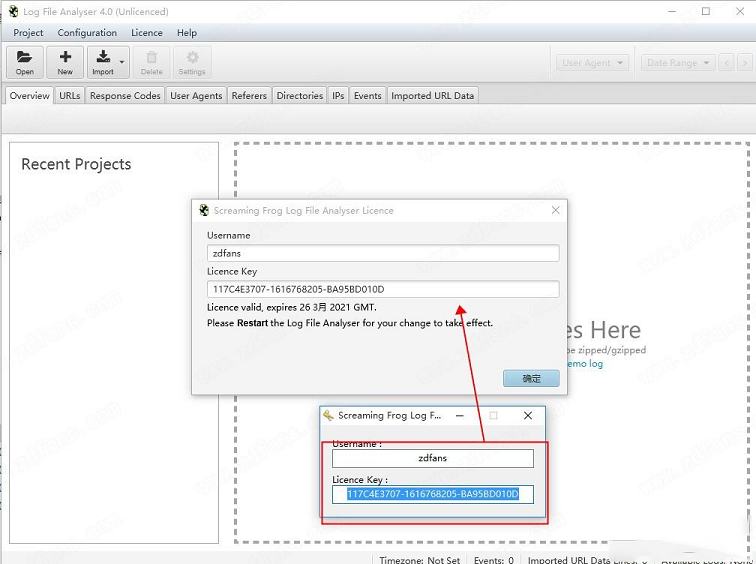

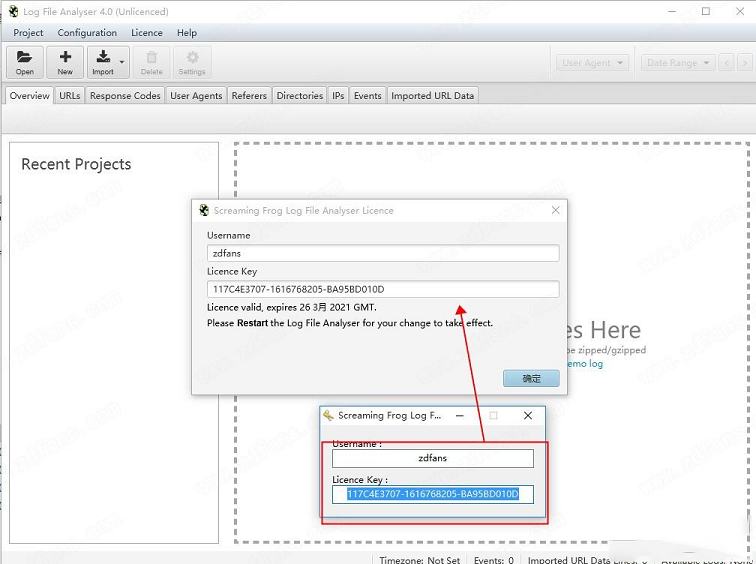

9、如图所示,运行注册机,在注册机中输入用户名即可自动生成许可证密钥,将注册信息对应复制到软件中,点击确定;

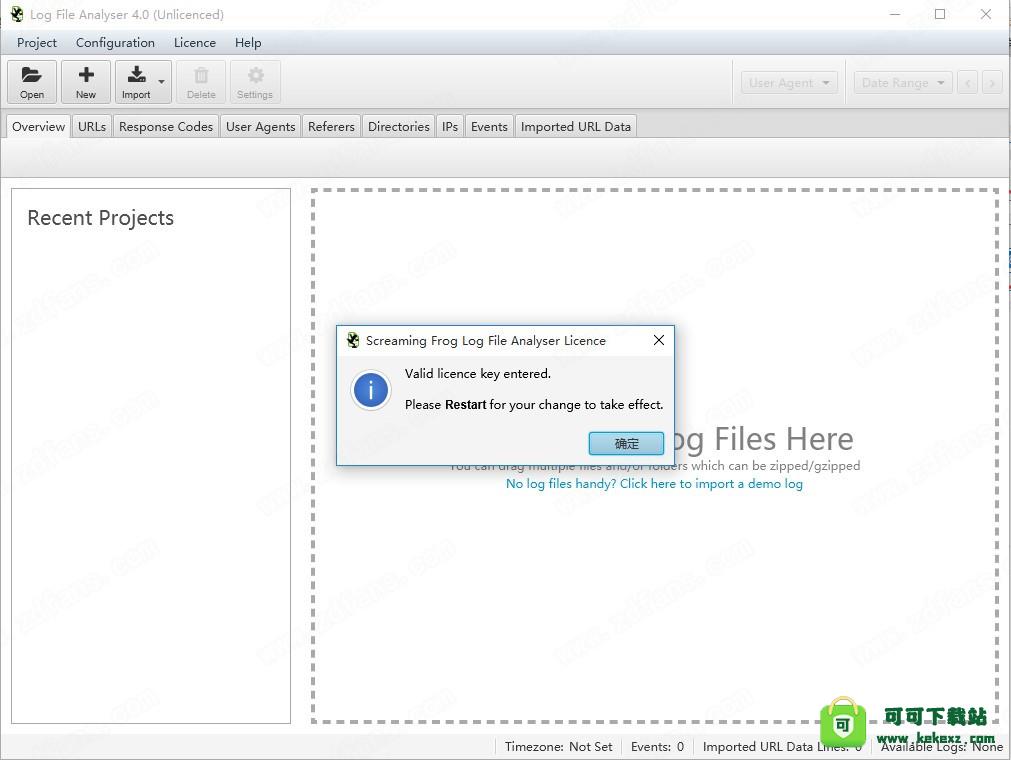

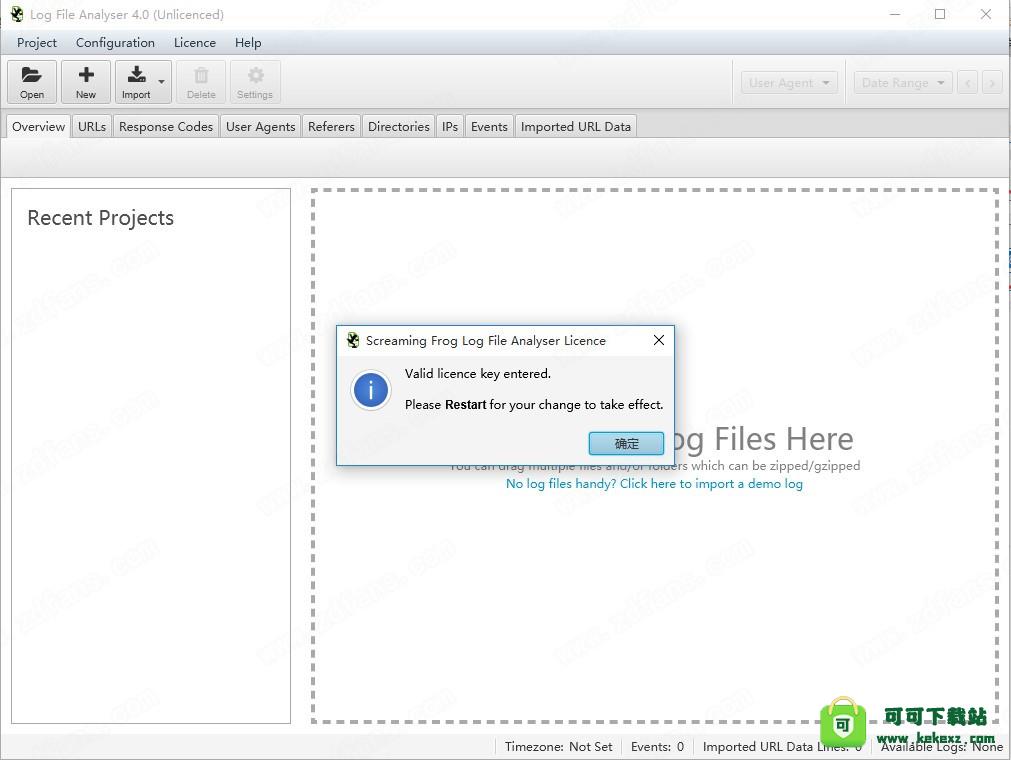

10、完成破解,点击确定,重新启动软件;

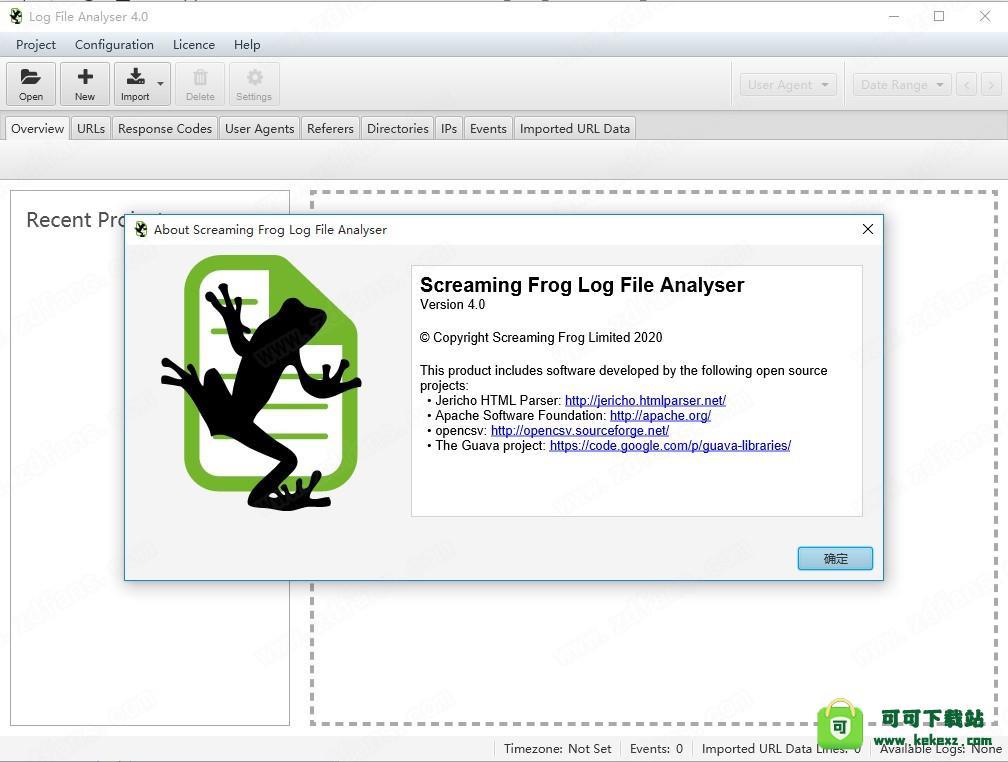

11、此时可以看到软件已经完成破解。

查看和分析Googlebot和其他搜索漫游器能够抓取的网址,时间和频率。

2、发现抓取频率

深入了解哪些搜索机器人最常抓取,每天抓取多少网址以及机器人事件总数。

3、找到断开的链接和错误

发现搜索引擎机器人在抓取您的网站时遇到的所有响应代码,损坏的链接和错误。

4、审核重定向

查找搜索机器人遇到的临时和永久重定向,这可能与浏览器或模拟爬网中的重定向不同。

5、改善抓取预算

分析您最常和最少爬网的网站和目录,以识别浪费并提高抓取效率。

6、识别大页面和慢速页面

查看下载的平均字节数以及识别大页面或性能问题所花费的时间。

7、查找未抓取和孤立页面

Screaming Frog Log File Analyzer可导入网址列表并与日志文件数据进行匹配,以识别Googlebot尚未抓取的孤立或未知网页或网址。

8、结合并比较任何数据

使用“URL”列对日志文件数据导入和匹配任何数据。因此,导入爬网,指令或外部链接数据以进行高级分析。

在尖叫青蛙日志文件分析仪是一个搜索引擎优化审计工具,通过真实的上市公司增发建有全球成千上万的用户。收集和分析的一些数据的快速摘要包括 -

1、已抓取的网址

查看和分析搜索漫游垃圾网(例如Googlebot和Bingbot)已抓取哪些网址。

2、抓取频率

分析搜索机构用户代理搜索最多和最少抓取的网址。

3、完整事件数据

按时间戳访问日志中发现的每个URL的完整日志文件事件数据。

4、错误

识别客户端错误,例如链接断开和服务器错误(4XX,5XX响应代码)。

5、重定向

查看永久和临时重定向(302或301响应)。

6、响应代码不一致

在一段时间内快速查看响应代码不一致的URL。

7、最后响应时间

准确查看搜索机器人上次抓取URL的时间(以及第一个以及其他所有事件!)。

8、平均字节数

直接从日志文件事件数据中分析每个已爬网URL的平均字节数。

9、平均响应时间(毫秒)

发现每个URL的平均响应时间。

10、Referers

查看发现的每个URL的引用事件数。

11、目录

分析最常和最不常被爬网的目录和站点部分。

12、未抓取的网址

导入网址列表并发现尚未抓取的网址。

13、孤立URL

导入URL列表并发现哪些是日志数据,但您不知道。

14、随着时间的推移分析机器人

一次或多次上传多个日志文件,以分析和测量机器人活动。

15、比较任何数据

使用“URL”标头上传任何数据,以自动匹配日志文件数据并进行分析。

16、验证搜索机器人

自动验证Googlebot等搜索机器人,并查看IP欺骗请求。

2、查找断开的链接,错误和重定向

3、查看最多和最少的已抓取网址和部分

4、查看Bot Crawl Frequency

5、查看Bot IP抓取活动

6、识别大型和慢速网址

7、查找未抓取和孤立的网址

8、结合并比较抓取数据

9、无记录事件限制

10、无项目限制

要创建一个新项目,你只需要单击顶部菜单中的“新建”按钮或“项目>新建”。然后系统会要求你为项目命名并选择时区。你也可稍后重命名该项目。

你还可单击“用户代理”选项卡以配置在项目中分析的用户代理。默认情况下,日志文件分析器仅分析搜索引擎机器人事件,因此请选中“筛选用户代理(改进的性能)”框。

在此窗口的底部,你还可选择在导入日志时“验证机器人”。这将使初始日志文件导入更长时间,或者你可在导入后执行此操作。

假如要分析每个URL,只需忽略此选项卡并将其留空。

假如日志文件中的URL是相对的而不是绝对的,则还会要求你提供完整的站点URL,包括协议(HTTP或HTTPS)。只需在窗口中输入URL即可。

2,打开现有项目

要打开现有项目,请单击顶部菜单中的“打开”按钮或“项目”>“打开”。

此外,你可使用“项目”>“打开”>“最近”从最近打开的项目列表中进行选择。

3,删除项目

要删除现有项目,请在所选项目的顶部菜单中单击“项目”>“删除”。

或者,你可单击顶部菜单中的项目>打开,突出显示要删除的项目,然后按窗口底部的删除按钮。

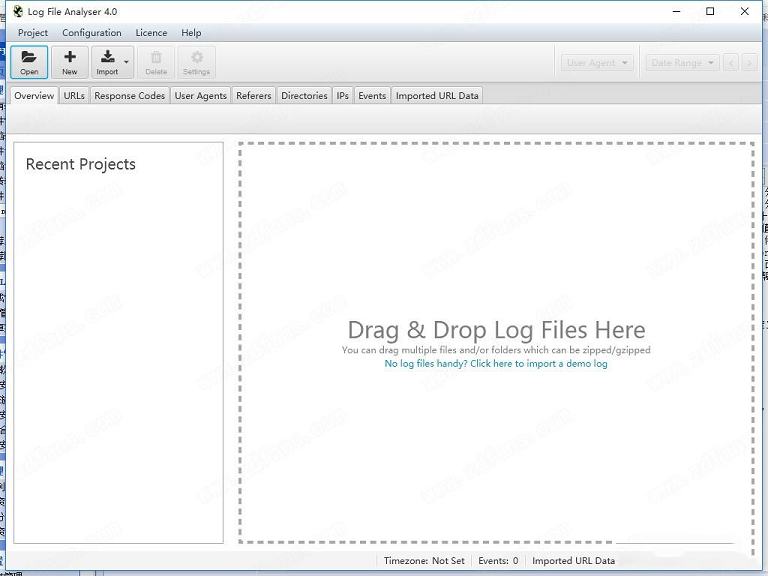

4,拖放日志文件

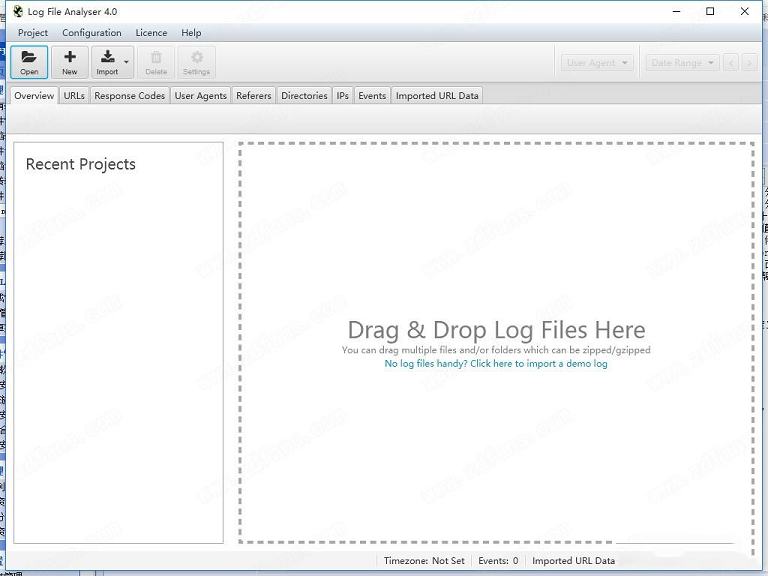

要导入日志文件,请在“导入的URL数据”选项卡以外的任何选项卡上将日志文件拖放到应用程序中。或者,你可使用顶部菜单中的“导入>日志文件”按钮或“项目>导入日志文件”选项。

当你打开一个新项目时,主窗口窗格将显示以下消息,你只需拖放日志文件即可

5,将其他日志文件导入项目

你可通过拖放将添加到项目中的数据而不是覆盖它的其他日志文件,以与上述相同的方式继续将其他数据导入现有项目。

假如你犯了错误或决定删除某些数据,则可在“项目”>“导入历史记录”下查看(并删除)导入。

6,导入抓取数据

你可导出Screaming Frog SEO Spider的“内部”选项卡,并将文件直接拖放到“导入的URL数据”选项卡窗口中。或者,你可使用顶部菜单中的“导入> URL数据”按钮或“项目>导入URL数据”选项。这将快速将数据导入到“日志文件分析器”的“导入的URL数据”选项卡和数据库中。

“导入的爬网数据”选项卡仅显示你导入的数据,而不显示其余数据。但是,你现在可使用URL和响应标记选项卡中提供的视图筛选器查看提取的数据以及日志文件数据。

日志文件解析器默认为“日志文件”,但假如你将视图更改为“与URL数据匹配”,它将显示爬网数据以及日志文件数据(向右滚动)。

“不在URL数据中”将显示在日志中找到但未在导入的爬网数据中找到的URL。这些可能是孤立的URL,现在重定向的旧URL,或者只是来自外部网站的错误链接。

“不在日志文件中”将显示在爬网中找到但未在日志文件中找到的URL。这些可能是搜索机器人未抓取的网址,也可能是最近发布的新网址。

7,删除导入的URL数据

你可通过单击顶部菜单选项中的“项目>清除URL数据”快速删除项目中的“导入的URL数据”。

请注意,删除数据后,除非再次导入数据,否则无法恢复。

破解教程

1、在本站下载解压软件得到安装包以及注册机;

2、双击ScreamingFrogLogFileAnalyser-3.0.exe运行安装,如图所示,选择安装方式,默认安装和自定义安装;

3、勾选Custom,如图所示,点击浏览选择软件安装路径,点击next;

4、选择要在其中创建程序快捷方式的“开始菜单”文件夹,默认即可点击next;

5、安装中,大家耐心等待一会儿;

6、安装完成,点击closet关闭;

7、运行软件,点击 Accept;

8、如图所示,依次选择Licence-enter Licence;

9、如图所示,运行注册机,在注册机中输入用户名即可自动生成许可证密钥,将注册信息对应复制到软件中,点击确定;

10、完成破解,点击确定,重新启动软件;

11、此时可以看到软件已经完成破解。

软件功能

1、识别已抓取的网址查看和分析Googlebot和其他搜索漫游器能够抓取的网址,时间和频率。

2、发现抓取频率

深入了解哪些搜索机器人最常抓取,每天抓取多少网址以及机器人事件总数。

3、找到断开的链接和错误

发现搜索引擎机器人在抓取您的网站时遇到的所有响应代码,损坏的链接和错误。

4、审核重定向

查找搜索机器人遇到的临时和永久重定向,这可能与浏览器或模拟爬网中的重定向不同。

5、改善抓取预算

分析您最常和最少爬网的网站和目录,以识别浪费并提高抓取效率。

6、识别大页面和慢速页面

查看下载的平均字节数以及识别大页面或性能问题所花费的时间。

7、查找未抓取和孤立页面

Screaming Frog Log File Analyzer可导入网址列表并与日志文件数据进行匹配,以识别Googlebot尚未抓取的孤立或未知网页或网址。

8、结合并比较任何数据

使用“URL”列对日志文件数据导入和匹配任何数据。因此,导入爬网,指令或外部链接数据以进行高级分析。

软件特色

日志文件分析器工具报告...在尖叫青蛙日志文件分析仪是一个搜索引擎优化审计工具,通过真实的上市公司增发建有全球成千上万的用户。收集和分析的一些数据的快速摘要包括 -

1、已抓取的网址

查看和分析搜索漫游垃圾网(例如Googlebot和Bingbot)已抓取哪些网址。

2、抓取频率

分析搜索机构用户代理搜索最多和最少抓取的网址。

3、完整事件数据

按时间戳访问日志中发现的每个URL的完整日志文件事件数据。

4、错误

识别客户端错误,例如链接断开和服务器错误(4XX,5XX响应代码)。

5、重定向

查看永久和临时重定向(302或301响应)。

6、响应代码不一致

在一段时间内快速查看响应代码不一致的URL。

7、最后响应时间

准确查看搜索机器人上次抓取URL的时间(以及第一个以及其他所有事件!)。

8、平均字节数

直接从日志文件事件数据中分析每个已爬网URL的平均字节数。

9、平均响应时间(毫秒)

发现每个URL的平均响应时间。

10、Referers

查看发现的每个URL的引用事件数。

11、目录

分析最常和最不常被爬网的目录和站点部分。

12、未抓取的网址

导入网址列表并发现尚未抓取的网址。

13、孤立URL

导入URL列表并发现哪些是日志数据,但您不知道。

14、随着时间的推移分析机器人

一次或多次上传多个日志文件,以分析和测量机器人活动。

15、比较任何数据

使用“URL”标头上传任何数据,以自动匹配日志文件数据并进行分析。

16、验证搜索机器人

自动验证Googlebot等搜索机器人,并查看IP欺骗请求。

软件亮点

1、Screaming Frog Log File Analyzer可自动验证搜索引擎机器人2、查找断开的链接,错误和重定向

3、查看最多和最少的已抓取网址和部分

4、查看Bot Crawl Frequency

5、查看Bot IP抓取活动

6、识别大型和慢速网址

7、查找未抓取和孤立的网址

8、结合并比较抓取数据

9、无记录事件限制

10、无项目限制

使用说明

1、建立一个新项目要创建一个新项目,你只需要单击顶部菜单中的“新建”按钮或“项目>新建”。然后系统会要求你为项目命名并选择时区。你也可稍后重命名该项目。

你还可单击“用户代理”选项卡以配置在项目中分析的用户代理。默认情况下,日志文件分析器仅分析搜索引擎机器人事件,因此请选中“筛选用户代理(改进的性能)”框。

在此窗口的底部,你还可选择在导入日志时“验证机器人”。这将使初始日志文件导入更长时间,或者你可在导入后执行此操作。

假如要分析每个URL,只需忽略此选项卡并将其留空。

假如日志文件中的URL是相对的而不是绝对的,则还会要求你提供完整的站点URL,包括协议(HTTP或HTTPS)。只需在窗口中输入URL即可。

2,打开现有项目

要打开现有项目,请单击顶部菜单中的“打开”按钮或“项目”>“打开”。

此外,你可使用“项目”>“打开”>“最近”从最近打开的项目列表中进行选择。

3,删除项目

要删除现有项目,请在所选项目的顶部菜单中单击“项目”>“删除”。

或者,你可单击顶部菜单中的项目>打开,突出显示要删除的项目,然后按窗口底部的删除按钮。

4,拖放日志文件

要导入日志文件,请在“导入的URL数据”选项卡以外的任何选项卡上将日志文件拖放到应用程序中。或者,你可使用顶部菜单中的“导入>日志文件”按钮或“项目>导入日志文件”选项。

当你打开一个新项目时,主窗口窗格将显示以下消息,你只需拖放日志文件即可

5,将其他日志文件导入项目

你可通过拖放将添加到项目中的数据而不是覆盖它的其他日志文件,以与上述相同的方式继续将其他数据导入现有项目。

假如你犯了错误或决定删除某些数据,则可在“项目”>“导入历史记录”下查看(并删除)导入。

6,导入抓取数据

你可导出Screaming Frog SEO Spider的“内部”选项卡,并将文件直接拖放到“导入的URL数据”选项卡窗口中。或者,你可使用顶部菜单中的“导入> URL数据”按钮或“项目>导入URL数据”选项。这将快速将数据导入到“日志文件分析器”的“导入的URL数据”选项卡和数据库中。

“导入的爬网数据”选项卡仅显示你导入的数据,而不显示其余数据。但是,你现在可使用URL和响应标记选项卡中提供的视图筛选器查看提取的数据以及日志文件数据。

日志文件解析器默认为“日志文件”,但假如你将视图更改为“与URL数据匹配”,它将显示爬网数据以及日志文件数据(向右滚动)。

“不在URL数据中”将显示在日志中找到但未在导入的爬网数据中找到的URL。这些可能是孤立的URL,现在重定向的旧URL,或者只是来自外部网站的错误链接。

“不在日志文件中”将显示在爬网中找到但未在日志文件中找到的URL。这些可能是搜索机器人未抓取的网址,也可能是最近发布的新网址。

7,删除导入的URL数据

你可通过单击顶部菜单选项中的“项目>清除URL数据”快速删除项目中的“导入的URL数据”。

请注意,删除数据后,除非再次导入数据,否则无法恢复。

∨ 展开

Wing FTP Server注册码注册机

Wing FTP Server注册码注册机

索尼克超级明星修改器 V1.0 Steam版

索尼克超级明星修改器 V1.0 Steam版

通达信公式破解器 V7.35 最新免费版

通达信公式破解器 V7.35 最新免费版

fscapturev9.6破解版

fscapturev9.6破解版

emby theater for windows V16.035 免费版

emby theater for windows V16.035 免费版

O&O Defrag Professional 25中文破解版

O&O Defrag Professional 25中文破解版

我的世界1.20纯净版 官方版

我的世界1.20纯净版 官方版

屏幕监控客户端 V1.0 绿色版

屏幕监控客户端 V1.0 绿色版

比亚迪官方dilink4.0升级包 最新免费版

比亚迪官方dilink4.0升级包 最新免费版

比亚迪车机系统升级包 V4.0 免费版

比亚迪车机系统升级包 V4.0 免费版

福昕PDF编辑器12破解补丁 V12.0.0.12394 绿色免费版

福昕PDF编辑器12破解补丁 V12.0.0.12394 绿色免费版

营业执照生成器破解版V8.0

营业执照生成器破解版V8.0

Alternative A2dp Driver(PC支持LDAC协议) V1.0.5.1 最新免费版

Alternative A2dp Driver(PC支持LDAC协议) V1.0.5.1 最新免费版

Eplan p8 2023破解文件 V2023 绿色免费版

Eplan p8 2023破解文件 V2023 绿色免费版

天猫精灵刷机破解软件 V2023 免费版

天猫精灵刷机破解软件 V2023 免费版

Studio One6机架效果插件 V6.0.2 最新免费版

Studio One6机架效果插件 V6.0.2 最新免费版